Le contenu de cette page a été écrit et publié sous la direction de l'Institut national des hautes études de la sécurité et de la justice (INHESJ) qui a rejoint l'Institut des hautes études du ministère de l'Intérieur (IHEMI) le 1er janvier 2021. Il était important pour la direction de l'IHEMI de conserver l'ensemble du contenu de l'INHESJ, qui constitue désormais la mémoire de l'institut.

Yann Lecun, professeur à l'Université de New York et scientifique en chef de l'IA chez Facebook, fait le point sur l'intelligence artificielle, les risques et opportunités qu'elle présente. Article issu de la revue DéfiS, n°8.

Vous dirigez depuis quatre ans le laboratoire d'Intelligence Artificielle (IA) de Facebook, le premier réseau social mondial. Et vous êtes à l'origine d'inventions majeures en IA, telles que le deep learning, perçu comme « un amplificateur d'intelligence ». Pouvez-vous donner une définition simple de ces technologies dites de « rupture » ? Quelle différence entre l'IA, le deep learning et le machine learning ?

Yann Lecun : Parmi les multiples définitions que l'on donne de l'IA, la plus simple est : « capacité des machines à prendre des décisions et à adopter des comportements attribués généralement à des humains ou à des animaux, mais avec un moindre niveau de performance ».

L'évolution technologique que nous connaissons depuis ces dix dernières années repose en grande partie sur le machine learning, à savoir, l'apprentissage automatique des machines. Le deep learning, sous domaine du machine learning, s'est quant à lui révélé particulièrement efficace et gagne en notoriété depuis ces quatre dernières années, si bien que les médias y font systématiquement référence lorsqu'ils parlent d'IA. Toute une industrie s'est créée autour de cette technologie.

Pour construire une machine intelligente les principales méthodes sont les suivantes :

- Il s'agit d'abord d'écrire des algorithmes qui se comportent de manière intelligente pour résoudre un problème particulier. A ce stade, les machines sont entraînées de manière totalement supervisée. Elles peuvent ainsi, par exemple, devenir un adversaire de taille dans une partie d'échec. Nous retrouvons ces mêmes algorithmes dans les Gps ou Google Maps pour planifier une trajectoire entre deux points. Mais, à ce stade, nous ne pouvons encore parler d'apprentissage.

- Ensuite, le machine learning classique. Il nécessite une part importante de programmation directe (conception à la main) de manière à transformer le signal original (par exemple, une image) en un format traitable par le système d'apprentissage simple. Cela implique également de collecter de grandes bases de données qui sont étiquetées à la main et d'assigner à la machine une tâche bien définie (entrée/sortie). La partie apprentissage est encore relativement mineure. Le machine learning représente plus de 95 % des succès de l'IA. Il est utilisé pour la reconnaissance d'images, la classification de textes ou encore pour la traduction automatique, notamment par Facebook, Google, Microsoft, IBM et beaucoup de start-up.

- Enfin, le deep learning, apprentissage profond ou par renforcement, repose sur l'utilisation de multiples couches d'unités de traitement de données composant un système. Il permet à ce dernier d'être entièrement entraînable (sans conception à la main) et d'apprendre de manière automatique. En 2010/2011, une série d'expériences démontra qu'il améliorait significativement les performances des systèmes de reconnaissance de la parole. C'est à partir de ce moment clé que le cheminement entre la recherche pure et la dérivation commerciale à très grande échelle est devenu extrêmement court. En l'espace de deux ans seulement, la plupart des systèmes de reconnaissance de la parole utilisait ainsi le deep learning. Quelques mois plus tard, le même phénomène se produisit dans le domaine de la reconnaissance d'image. Grâce à des bases de données colossales, le deep learning permet de produire des performances exceptionnelles, bien meilleures que celles réalisées jusqu'à présent, en réduisant considérablement le taux d'erreurs.

Cette technologie se généralise. Ses applications se sont multipliées, notamment en matière de reconnaissance du visage, de voiture autonome, ou encore de traitement de l'imagerie médicale. L'utilisation du deep learning et du réseau collectif dans ce dernier domaine va entraîner une révolution en médecine dans les années à venir. On commence également à assister à une révolution similaire concernant la compréhension et le traitement de la langue naturelle. Le deep learning est surtout devenu la pièce maîtresse de l'industrie de l'Internet, qui l'utilise notamment pour le filtrage des contenus et des résultats de recherche.

La généralisation des systèmes automatisés aux traducteurs, rédacteurs, avocats, conducteurs, chirurgiens etc., implique une transformation des métiers, des compétences et plus globalement de notre rapport au travail. Quelle est votre vision ? Certains titres traduisent les peurs et les fantasmes autour d'un avenir dominé par les technosciences dont on ne mesure pas encore les conséquences sur l'organisation sociétale.

Y.L. : La vitesse de croissance et le potentiel de transformation de ces technologies peuvent expliquer la difficulté que nous avons à percevoir justement les révolutions technologiques et leurs conséquences sur l'avenir. D'où certains discours pessimistes sur les transformations à long terme. Comment aurions-nous pu prévoir, par exemple, en 1900, que 50 ou 60 ans plus tard les gens traverseraient la planète en avion ? Depuis le 19e siècle, le progrès technologique, quel qu'il soit, déplace les métiers dans une logique de destruction créatrice. L'IA, à son tour, fait évoluer les métiers et nous amène à reconsidérer la valeur que l'on attribue à certaines activités. Le travail physique, par exemple, est substituable au travail des machines. Les métiers complémentaires de l'IA, qui font davantage appel à l'analyse et à l'intelligence humaine, seront non substituables et, par conséquent, valorisés. Je ne pense pas, personnellement, que l'émergence de l'IA soit qualitativement différente d'autres progrès technologiques. La vraie différence est le temps d'appropriation et d'intégration de l'IA dans le fonctionnement social. La rapidité de son développement et de son exploitation commerciale rend plus difficile le nivellement des compétences. Il y aura probablement plus de laissés pour compte. Les bouleversements sociétaux ne sont pas intrinsèquement liés à l'IA mais plutôt à l'accélération du progrès technologique en général.

Quels sont et quels vont être les principaux marqueurs de ces changements ?

Y.L. : Tout d'abord, ces technologies vont faire évoluer certains métiers et faire gagner en performance certaines activités. Nous pouvons déjà en mesurer les effets dans les secteurs de l'automobile et de la santé. Concernant le métier de chauffeur de véhicule, l'intérêt va être de réduire les risques et probablement les accidents de la route, notamment ceux liés à l'erreur humaine. Pour les radiologues, l'identification des cas simples par filtrage des images leur permettra de s'orienter directement sur les cas complexes qui requièrent un diagnostic approfondi. L'IA permettra tant de réduire les délais entre la prise en charge et les diagnostics que les coûts.

Ensuite, la création d'assistants virtuels intelligents avec lesquels nous pourrons dialoguer, va bouleverser très certainement les relations interpersonnelles. Ces agents intelligents seront des sortes d'extensions de notre personnalité avec lesquels nous pourrons interagir en permanence et de manière très directe. Ils augmenteront nos capacités, un peu comme le papier et le crayon nous ont permis d'augmenter notre mémoire, mais de manière beaucoup plus efficace et personnalisée.

Un autre marqueur important, que l'on observe déjà aujourd'hui, réside dans le déplacement des valeurs. L'automatisation accrue des processus de manufacture engendre une réduction des prix de fabrication si bien que la valeur attribuée à certains biens matériels se déplace vers l'authenticité de la production humaine, de la créativité, du contact humain. C'est ce qui explique que l'on peut se procurer pour seulement 50 euros en magasin un lecteur Blu-ray, objet technologique incroyablement compliqué, qui requiert des technologies fabriquées partout dans le monde. A contrario, un pot de terre fabriqué par un artisan local avec un savoir-faire très ancien peut vous coûter 500 euros ! La différence de prix observée entre une place de concert et un album accessible en streaming illustre également ce déplacement de valeur.

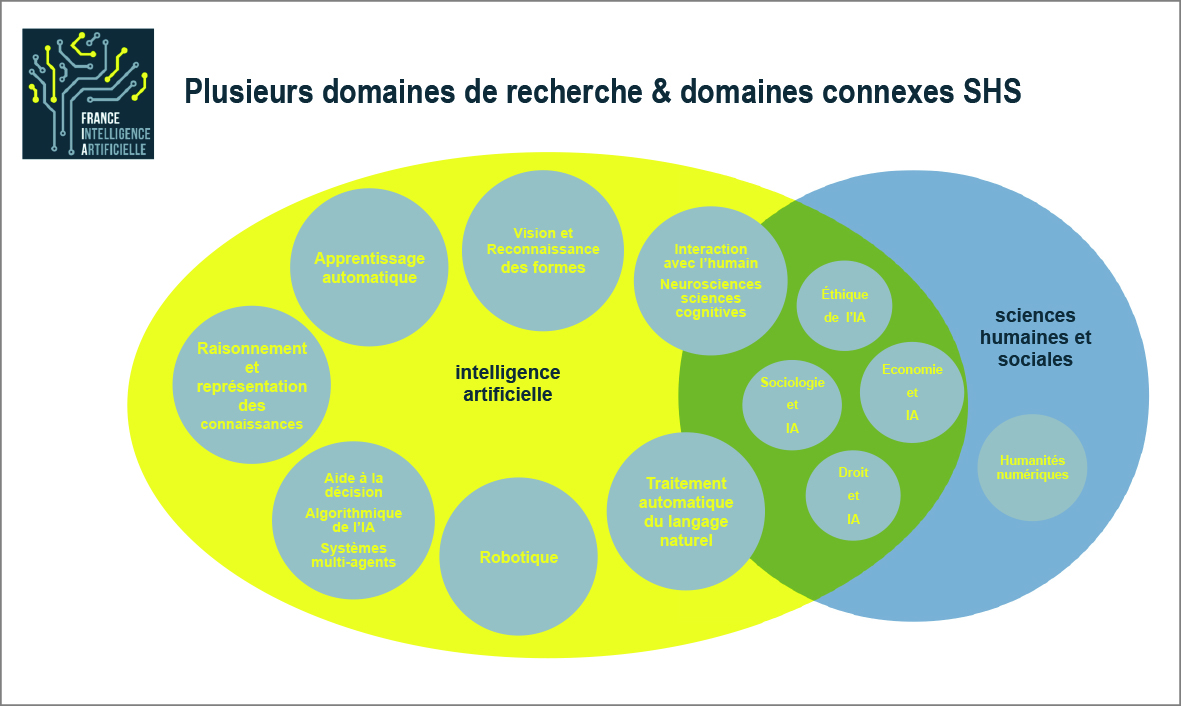

Figure 1 : plusieurs domaines de recherche et domaines connexes SHS.

Réfléchir, parler, décider ne seraient plus des qualités proprement humaines ? En Chine, la société DKV (Deep knowledge ventures) de Hong Kong a été la première en 2014 à nommer un algorithme à son conseil d'administration. Jusqu'où va nous amener le deep learning ? La machine capable d'interagir avec son environnement de façon autonome, voire consciente, est-elle un mythe ou une utopie aujourd'hui réalisée ? Quelle nouvelle place pour l'Homme dans un environnement reconfiguré avec et par l'IA ?

Y.L. : Nous sommes encore au stade exploratoire de l'IA et manquons de repères pour en définir les limites. Dans certains domaines spécifiques, l'on constate déjà que les machines peuvent dépasser les performances humaines relativement facilement. L'ampleur des possibilités qu'offre l'IA nous force, une nouvelle fois dans l'histoire des sciences, à nous interroger sur les propres limites de l'intelligence humaine. Précisément, l'IA permet d'amplifier notre intelligence et donc d'accroître notre pouvoir. Mais ne nous y trompons pas, elle constitue une opportunité pour l'Homme et non une menace, à la condition qu'elle reste sous notre contrôle. Les machines seront-elles un jour capables de prendre des décisions autonomes et conscientes comme l'être humain ? Encore faudrait-il qu'elles possèdent les trois composants essentiels de l'intelligence que sont la capacité à prédire, celle de produire une séquence d'actions en vue d'obtenir un résultat précis ainsi que l'intention qui nous conduit à prendre des décisions. Les machines en seront-elles un jour pourvues ? C'est une question encore abstraite qui relève plutôt de la philosophie et de la prospective. Mais admettons que nous parvenions à créer des machines intelligentes, animées par des intentions propres, aucun argument scientifique et rationnel ne peut nous laisser croire qu'elles reproduiront un scénario à la Matrix.

D'autres innovations majeures sont-elles à prévoir en matière d'IA ? Facebook a racheté l'entreprise WIT.AI axée sur les chat bot (agents conversationnels). Quels sont les prochains challenges ? En quoi ces innovations représentent-elles un réel progrès pour les entreprises, les utilisateurs/consommateurs ?

Y.L. : Le rachat de WIT.AI a donné lieu à une collaboration entre ceux qui connaissaient les produits d'agent conversationnel avec ceux qui maîtrisaient davantage la recherche et le deep learning. C'est précisément à travers ce type de collaboration entre la science et l'industrie de service que nous faisons progresser la technologie en la rendant beaucoup plus utile.

D'ici cinq ans, nous assisterons à de nouveaux progrès dans les technologies d'agent conversationnel. La reconnaissance de la parole, la compréhension et la génération de texte pourront s'effectuer à l'appui de systèmes capables de répondre à n'importe quelle question dont la réponse est présente quelque part sur le web. Certains s'en approchent mais dépendent encore du filetrex de l'utilisateur et font appel au cross-sourcing plus qu'à l'IA pour donner la bonne réponse. D'autre part, la plupart des systèmes utilisés sur les sites de vente en ligne sont encore très cognitifs.

Ces trois dernières années, Facebook s'est organisé principalement autour du machine learning et, plus précisément, du deep learning. D'autres défis sont à relever par la recherche fondamentale et l'ingénierie, qui représentent un effort d'investissement considérable. Et si le deep learning est très performant quand il s'agit de reproduire nos fonctions de perception (visuelle, auditive, etc.), nous devons désormais progresser vers un nouveau mode d'apprentissage qui nous permettra de générer des systèmes ayant une capacité de raisonnement. Ce mode d'apprentissage par renforcement est performant mais ne marche pas dans le monde réel ! Il implique encore trop d'essais et d'erreurs pour mener à bout des projets qui engagent la vie humaine et l'organisation urbaine, tels que, par exemple, la création de voitures autonomes ou d'humanoïdes. Multiplier des parties de jeu de Go virtuelles pour qu'un système devienne maître en la matière (AlphaGo de Deepmind ), c'est réalisable, mais procéder à des millions d'essais pour que celui-ci conduise parfaitement une voiture de manière autonome engagerait une prise de risque trop importante.

C'est avec l'apprentissage prédictif que nous arriverons, dans les prochaines années, à créer des machines totalement autonomes, capables de prédire des actions futures et de réagir de manière adéquate avant que celles-ci ne se réalisent, comme le font les humains et les animaux. L'apprentissage prédictif ou non supervisé, constitue le prochain grand défi de la recherche fondamentale.

Admettons que ces robots, qui nous assisteront dans nos tâches quotidiennes, soient doués d'une certaine intelligence, pouvons-nous pour autant parler d'empathie ?

Y.L. : L'intelligence n'implique pas systématiquement l'empathie et inversement. Les robots, dont la tâche strictement définie n'impliquera aucune interaction avec les humains, seront intelligents mais non empathiques. Par contre, les agents individuels humanoïdes, qui eux nous assisteront au quotidien, devront le plus justement possible comprendre nos besoins, nos attentes, voire nos aspirations et réagir de façon adaptée. En cela, ils seront empathiques.

Plus largement, à partir du moment où nous inculquerons aux machines un modèle d'humanité, de société, il faudra qu'elles soient en capacité d'adopter un comportement en adéquation avec ces valeurs. De la même façon que l'on éduque des enfants, nous devrons entraîner les assistants virtuels humanoïdes à se comporter correctement en société. Cela implique de partager un socle de valeurs communes entre civilisations, et de définir ce que sont l'éthique, la morale, le bien commun ou encore les règles régissant les interactions sociales. Mais attention, la façon dont nous définissons l'intelligence n'est pas neutre et peut comporter certains stéréotypes proches des scénarios de science-fiction à la Terminator, où la machine de guerre intelligente veut systématiquement dominer le monde. Cela peut nous amener à conditionner les machines intelligentes du futur.

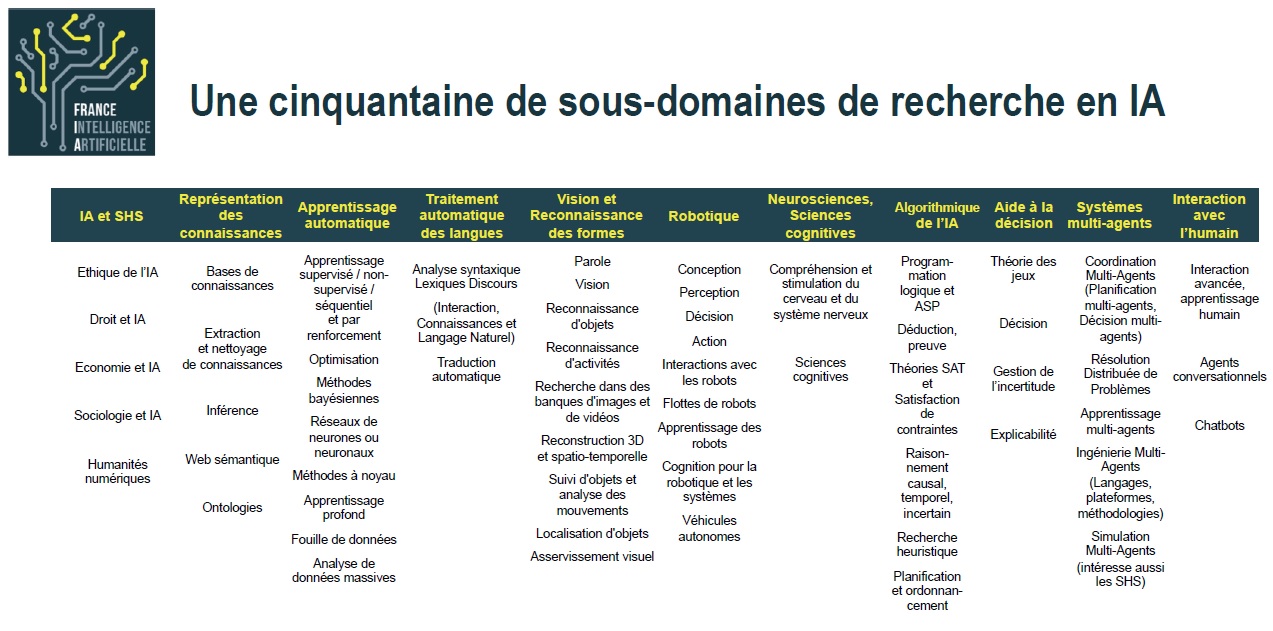

Figure 2 : une cinquantaine de sous-domaines de recherche en IA.

Le développement d'une société de la connaissance ne risque-t-il pas de créer des inégalités encore plus criantes entre des individus correctement dotés pour évoluer dans ces environnements « intelligents » et d'autres qui ne le seront pas. Un risque n'est-il pas de susciter des réactions radicales, voire violentes ?

Y.L. : Pour tout vous dire, c'est probablement la principale conséquence néfaste du progrès de l'IA qui m'inquiète. En effet, les sociétés ont toujours éprouvé des difficultés à intégrer les changements technologiques. Les grands bouleversements et crises liés à la révolution industrielle en sont une illustration dans l'histoire. Aujourd'hui, les systèmes sociaux des pays européens permettent de mieux intégrer l'accélération du progrès technologique, contrairement aux États-Unis où l'on assiste à une forte croissance des inégalités. Il va falloir sérieusement repenser le contrat social dans les distributions des richesses. La mise en place d'un revenu minimum universel est une solution à laquelle il faut réfléchir.

Les IA ne risquent-elles pas de devenir le cheval de Troie pour servir des intérêts industriels, gouvernementaux ou communautaires ? Par exemple, aux États-Unis, la proximité entre l'industrie et l'appareil d'État réunis autour d'une stratégie commune de puissance est un atout mais aussi un risque ? Certains perçoivent ces enjeux de puissance comme une menace pour la démocratie et l'humanité. Quelle place donnez-vous à ces discours et, d'après vous, quels sont les risques réels ?

Y.L. : L'inquiétude de l'opinion est légitime au regard du monopole grandissant des géants de l'industrie de l'Internet et de l'omniprésence de l'IA dans la vie quotidienne. Qu'il s'agisse de la manipulation au service d'intérêts commerciaux, d'un État ou d'une idéologie, certains risques sont, en effet, à prendre en compte.

Un premier type de risque, inhérent aux technologies, est relatif aux biais sur lesquels les systèmes ont été entraînés volontairement. Nous devons rester vigilants sur le fait que certains travaux serviront potentiellement des intérêts contraires à l'éthique ou au bien commun ! Prenons l'exemple d'une compagnie étrangère qui développe un système de détection de la criminalité par reconnaissance d'image. Dans un contexte de lutte contre le terrorisme, les dérives sont évidentes. Autre exemple : imaginons des entreprises utiliser abusivement des biais systématiques pour booster leurs ventes et duper les consommateurs !

Un second type de risque est lié au fait que les industries sont, évidemment, dans l'impossibilité de prévoir et contrôler toutes les utilisations détournées de leurs inventions. Prenons l'exemple de « Tay », l'agent conversationnel de Microsoft, capable de participer à des conversations sur des réseaux sociaux et des applications de messagerie, en apprenant notamment de ses interactions avec les internautes. Lancée, en mars 2016, sur Twitter, sous les traits d'une adolescente, l'IA fut retirée du réseau social quelques heures à peine après sa mise en fonction. Sur la base de ce qui lui était enseigné par quelques utilisateurs, coordonnés pour abuser de ses capacités afin de la pousser à répondre de façon inappropriée, Tay s'était mise, en effet, en moins de 24h à multiplier les tweets pro-nazis et racistes. Ce n'était bien entendu pas prévu par Microsoft et difficilement prévisible dans l'absolu. Le facteur culturel ajoute aussi une incertitude quant à un développement mondialisé de ces systèmes. L'expérimentation de « Tay » en Chine a été une réussite. Nous devons anticiper ce genre de dérives, c'est aussi l'intérêt de Parternship on AI.

Comment éviter ces écueils ? Une forme de contrôle non contraignante est-elle possible ? Sommes-nous capables d'objectiver nos propres biais, les valeurs que nous inculquons aux systèmes sont-elles réellement légitimes ? A qui d'en décider ? A l'État ? Aux géants de l'Internet ? Est-ce le sens de Partnership on AI qui a été monté en septembre 2016 avec les GAFAM pour prévenir des dérives/menaces inhérentes au développement de ces technologies ?

Y.L. : Notons que la posture des populations et des gouvernements vis-à-vis des compagnies telles que Google ou Facebook peut être très différente d'un pays à l'autre. En Europe, par exemple, les citoyens ont très peur de l'ingérence des compagnies privées dans leurs données personnelles, bien plus que de celle des gouvernements. Aux USA, c'est le contraire. Le facteur culturel complexifie l'action des industries dans certains pays. Elles restent, ainsi, assujetties aux règles et aux lois de chaque pays. En Chine, par exemple, les demandes d'accès aux données privées de la part du gouvernement empêchent Facebook ou Google d'opérer.

Par ailleurs, il est effectivement impératif d'anticiper les dérives de l'IA. C'est dans cette optique que le Partnership on AI a ainsi été fondé par les géants du secteur, Amazon, DeepMind / Google, Facebook, IBM et Microsoft. Organisme à but non lucratif, il a en effet pour objet de faire progresser la compréhension publique des technologies de l'IA et de formuler les meilleures pratiques sur les défis et les opportunités dans le domaine, et ce en faveur des personnes et de la société.

Bien que les membres fondateurs participent à la fois financièrement et aux recherches, ils partagent la prise de décisions avec des tiers indépendants dont des universitaires, des défenseurs des groupes d'utilisateurs et des experts du domaine de l'industrie. Participe notamment au comité de direction, Jason Furman, l'ancien directeur économique de l'administration d'Obama qui a réfléchi aux conséquences économiques et aux risques sociétaux liés au développement de l'IA.

Depuis, d'autres organisations de natures et origines diverses, telles que l'association américaine de défense des libertés civiles (ACLU), l'Unicef, l'entreprise japonaise Sony, le think tank hongkongais Digital Asia Hub ou encore l'organisation à but non lucratif indienne The Center for Internet and Society (CIS), ont rejoint ce partenariat. Ce sont des organisations qui ont un intérêt dans le déploiement de l'IA et qui souhaitent prévenir les dérives, sociétales essentiellement.

À travers des comités de discussion, ces organisations peuvent ainsi échanger sur les questions d'éthique, d'équité, de transparence, de confidentialité ou encore de fiabilité de la technologie. Les résultats des recherches font l'objet d'une publication sous licence ouverte. L'objectif est de prévenir la création des biais systématiques lorsqu'on déploie un système à base de machine learning et d'IA et d'éviter que l'industrie ne s'égare. Ce partenariat n'a toutefois pas pour intention de faire du lobbying auprès des gouvernements ou autres organismes en charge d'élaborer les politiques.

La question de la capacité d'adaptation se pose aussi pour les entreprises. Arriveront-elles à prendre le tournant de ces transformations ? Quelles seront les conséquences pour celles qui n'en auront pas les moyens ou qui n'auront tout simplement pas saisi les enjeux au bon moment ? Ne risque-t-on pas, là encore, d'assister à un développement économique à double vitesse, avec une forte suprématie des GAFAM et de la Chine qui s'impose déjà ?

Y.L. : Aujourd'hui, un dirigeant d'entreprise doit prendre en compte assez rapidement ce changement pour se positionner sur les marchés porteurs et tirer parti de la situation plutôt que de la subir. Cela implique, dans certains cas, de changer d'orientation stratégique, de transformer les métiers, des évolutions de compétences, d'intégrer de nouveaux modèles de développement, etc.

En Europe, l'innovation a besoin d'un cadre favorable à la prise de risques, à la création d'entreprises. Sans faire l'apologie de leur système, les États-Unis ont su créer un terreau pour la création d'entreprises dans le domaine de l'IA, notamment à travers le financement de la recherche, le soutien au développement ou encore grâce aux transferts de technologie. Et il faut reconnaître que l'entrepreneuriat est un peu plus vivace aux États-Unis qu'en Europe. C'est ce qui explique en partie pourquoi le mouvement de l'IA a été impulsé aux États-Unis, que les GAFAM soient américains et qu'ils arrivent à absorber dans le monde entier les meilleurs chercheurs et les start-up les plus prometteuses.

L'Europe doit impérativement revaloriser les travaux et les métiers de la recherche, qui sont les moteurs de l'innovation et aussi son principal atout. Cela commence par l'attractivité des salaires.

En dehors des revues, des rapports parlementaires et des politiques publiques qui ont une portée relative, comment susciter davantage la prise de conscience en France des enjeux liés au développement de l'IA ? Quels seraient, d'après-vous, les leviers qu'il serait urgent d'activer ?

Y.L. : Je répondrai en qualité de chercheur et non d'économiste ou de politicien que je ne suis pas. Il faut commencer par conduire des actions qui attirent les chercheurs, qui créent des carrières en France et en Europe, plus généralement, soit dans le milieu universitaire soit dans la recherche publique. Aux États-Unis, les financements publics vont directement dans les universités et sont attribués de manière compétitive. Il y a relativement peu de recherche publique dans le domaine technologique. Ce système est difficilement reproductible en France, il se heurte à de nombreuses résistances, à commencer par la culture profondément jacobine. Un des principaux freins à l'innovation scientifique et technologique est l'excès de contrôle. Le niveau des formations scientifiques en France est excellent. La qualité des instituts de recherche tels que l'INRIA, par exemple, et de certaines universités y contribue. Mais les institutions sont trop rigides et devraient laisser plus de liberté à la recherche. Cela devrait constituer la priorité de l'Agence national pour la recherche.

Le temps de la recherche et de l'innovation est difficilement contrôlable aujourd'hui. Demander aux chercheurs de se former, de travailler sur un sujet particulier pendant 3 ans n'a plus de sens, parce qu'en trois ans, le domaine change. Il faut leur laisser la possibilité d'être opportunistes et de prendre des risques sur des sujets qu'ils estiment porteurs. Les systèmes de contrôle des financements ou l'organisation hiérarchique des tâches ne sont pas compatibles avec la logique de recherche exploratoire. Aux États-Unis, chaque professeur, même pré-junior a, par exemple, l'avantage de gérer une entreprise autonome.

Entretien avec Yann Lecun, 2017

Source figures 1 et 2 : France Intelligence Artificielle, Paris 21 mars 2017

Crédit photo : @franckinjapan - unsplash.com

Citer cet article : LECUN Y., « Apprendre aux machines à penser : un défi majeur pour l'économie ? Un progrès pour l'humanité ? », DéfiS (revue de l'INHESJ), 2017 (n°8 « L'entreprise à l'heure de l'intelligence artificielle : entre promesses et nouveaux défis »), pp. 9-14.

Bibliographie

- DE GANAY Claude, député, et GILLOT Dominique, sénatrice, « Rapport au nom de l'office parlementaire d'évaluation des choix scientifiques et technologiques pour une intelligence artificielle maîtrisée, utile et démystifiée » : https://histoiresduniversites.files.wordpress.com

- Executive Office of the President of the United States, National Science and Technology Council and Committee on Technology, “Preparing for the future of artificial intelligence”, October 2016: https://obamawhitehouse.archives.gov

- Executive Office of the President of the United States, “Artificial Intelligence, Automation, and the Economy”, December 2016: https://www.whitehouse.gov

- FURMAN Jason, “Is This Time Different ? The Opportunities and Challenges of Artificial Intelligence”, July 2016 : https://obamawhitehouse.archives.gov

- FURMAN Jason, in AINow : https://artificialintelligencenow.com/schedule/conference/speaker/jason-furman

- LOUBIERE Paul, « Attention danger : les GAFAM en embuscade dans les écoles françaises », in Challenges, 2 juin 2017 : https://www.challenges.fr

- TUAL Morgane, « L'Intelligence artificielle reproduit aussi le sexisme et le racisme des humains », in Le Monde, 15 avril 2017 : http://www.lemonde.fr

Derrière cet article